Аппроксимация Лапласа (пример)

Материал из MachineLearning.

Аппроксимация Лапласа - способ оценки параметров нормального распределения при апроксимации заданой плотности вероятности.

Содержание |

Постановка задачи

Задана выборка — множество значений свободных переменных и множество

соответствующих им значений зависимой переменной.

Необходимо для выбранной регрессионной модели

:

3-1 показать зависимость среднеквадратичной ошибки от значений параметров модели: ;

3-2 построить график и сделать апроксимацию Лапласа для нее;

3-3 найти расстояния между получеными зависимостями, используя расстояние Кульбака - Лейблера.

Описание алгоритма

При востановлении регрессии рассматривалась следующая гипотеза порождения данных:

В таком случае, при фиксированной модели f плотность вероятности появления данных равняется[1]:

- это функция регрессионных невязок, т.е.

;

- нормировачный коэффициент.

3-1. В заданной модели f, используя метод наименьших квадратов, находим оптимальное значение вектора параметров . Далее, фиксируем все параметры выбранной регрессионной модели (для определенности зададим им оптимальные значения) кроме одного (пусть этот незафиксированный параметр будет w(1)). После чего, варируя значение w(1), строим искомую зависимость

и его график. Таким образом построена зависимость от одного параметра w(1). Аналогично действуя, строится зависимость от большего количества параметров.

3-2.

3-3. Расстояние Кульбака - Лейблера между двумя распределениями p(z) и q(z) равняется:

Вычислительный эксперимент

Обозначим плотность распределения SSE как , а его апроксимация лапласса

.

Пример 1

Задуманная функция . Рассматривается линейная регрессионная модель с двумя параметрами:

.

и

- оптимальное значение параметров (при которых SSE минимально).

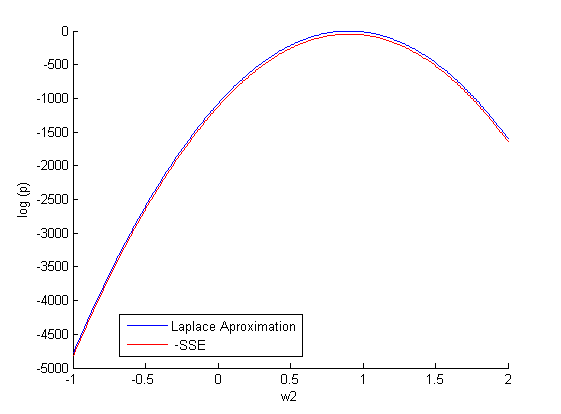

Фиксируем один параметр и задаем различные значение

(500 случайных значений на отрезке [-1;2]). Строим зависимость:

.

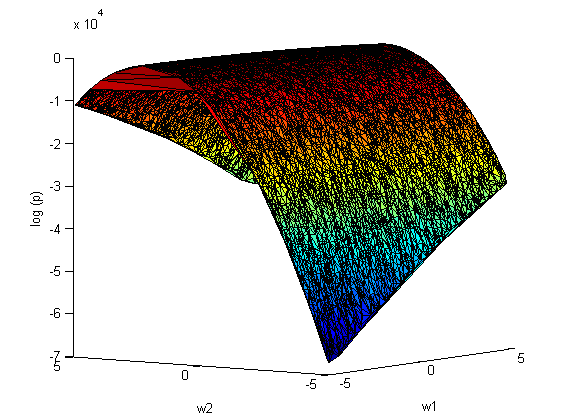

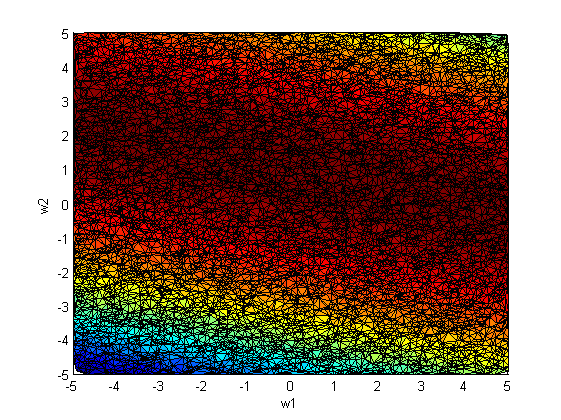

Повторим эксперимент, только теперь варируем сразу оба параметра и

:

апроксимация Лапласса:

На рис.2 наблюдается зависимость между коэффициентами и

. Следовательно, ковариационная матрица

не будет диагональной.

Смотри также

Литература

- Bishop, C. Pattern Recognition And Machine Learning. Springer. 2006.

Примечания

| | Данная статья является непроверенным учебным заданием.

До указанного срока статья не должна редактироваться другими участниками проекта MachineLearning.ru. По его окончании любой участник вправе исправить данную статью по своему усмотрению и удалить данное предупреждение, выводимое с помощью шаблона {{Задание}}. См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |