Сеть радиальных базисных функций

Материал из MachineLearning.

м (→Понятие радиальной функции: оформление) |

|||

| (5 промежуточных версий не показаны.) | |||

| Строка 3: | Строка 3: | ||

== Понятие радиальной функции == | == Понятие радиальной функции == | ||

| - | '''Радиальная функция''' — это функция <tex>f(x)</tex>, зависящая только от расстояния между x и фиксированной | + | '''Радиальная функция''' — это функция <tex>f(x)</tex>, зависящая только от расстояния между <tex>x</tex> и фиксированной точкой пространства <tex>X</tex>. <br /> <br /> |

| - | + | ||

Для определения наших радиальных функий введем метрику: <br /> | Для определения наших радиальных функий введем метрику: <br /> | ||

[[Нормальное распределение]] (гауссиан) <tex>p_j(x) = N(x; \mu _j ,\Sigma _j)</tex> с диагональной матрицей ковариации <tex>\Sigma _j</tex> можно записать в виде <br /> <br /> | [[Нормальное распределение]] (гауссиан) <tex>p_j(x) = N(x; \mu _j ,\Sigma _j)</tex> с диагональной матрицей ковариации <tex>\Sigma _j</tex> можно записать в виде <br /> <br /> | ||

| Строка 19: | Строка 18: | ||

== Решение задачи == | == Решение задачи == | ||

Пусть <tex> |Y| = M</tex> - число классов, каждый класс <tex>y \in Y</tex> имеет свою плотность | Пусть <tex> |Y| = M</tex> - число классов, каждый класс <tex>y \in Y</tex> имеет свою плотность | ||

| - | распределения <tex>p_y(x)</tex> и представлен частью выборки <tex>X ^l _y = \{(x_i, y_i) \in X ^l | y_i = y \}</tex>. <br /> <br /> | + | распределения <tex>p_y(x)</tex> и представлен частью [[выборка|выборки]] <tex>X ^l _y = \{(x_i, y_i) \in X ^l | y_i = y \}</tex>. <br /> |

| + | Здесь <tex>Y</tex> - множество ответов (классов),<tex>y \in Y</tex> , | ||

| + | <tex>x_i</tex> принадлежит множеству объектов <tex>X</tex> <br /><br /> | ||

===Гипотеза=== | ===Гипотеза=== | ||

Плотности классов <tex>p_y(x), y \in Y</tex> , представимы в виде | Плотности классов <tex>p_y(x), y \in Y</tex> , представимы в виде | ||

| Строка 28: | Строка 29: | ||

<tex> p_y(x) = \sum ^{k _y} _{j = 1} \omega _{yj} p _{yj}(x), </tex> - смесь плотностей <br /> | <tex> p_y(x) = \sum ^{k _y} _{j = 1} \omega _{yj} p _{yj}(x), </tex> - смесь плотностей <br /> | ||

<tex>p_{yj}(x) = N(x; \mu _{yj} ,\Sigma _{yj}), </tex> - плотность каждой компоненты смеси (имеет вид гауссианы)<br /> | <tex>p_{yj}(x) = N(x; \mu _{yj} ,\Sigma _{yj}), </tex> - плотность каждой компоненты смеси (имеет вид гауссианы)<br /> | ||

| - | <tex> \Sigma ^{k_y} _{j = 1} \omega _{yj} = 1, \omega _{yj} > 0;</tex> - условия | + | <tex> \Sigma ^{k_y} _{j = 1} \omega _{yj} = 1, \omega _{yj} > 0;</tex> - условия нормировки и неотрицательности весов<br /> <br /> |

===Алгоритм классификации=== | ===Алгоритм классификации=== | ||

Запишем основную формулу [[байесовский классификатор|байесовского классификатора]] | Запишем основную формулу [[байесовский классификатор|байесовского классификатора]] | ||

| - | <tex>a(x) = argmax _{y \in Y} \lambda _y P _y p_y(x)</tex>, | + | <tex>a(x) = argmax _{y \in Y} \lambda _y P _y p_y(x)</tex>. Здесь <tex>Y</tex> - множество ответов (классов), |

| + | <tex>x</tex> принадлежит множеству объектов <tex>X , P_y</tex> - априорная вероятность класса <tex>y , p_y(x)</tex> - функция правдоподобия класса <tex>y , \lambda_{y}</tex> - цена ошибки на объекте класса <tex>y</tex>. Выразим плотность каждой компоненты <tex>p_{yj}(x)</tex> через взвешенное евклидово расстояние от объекта x до центра компоненты <tex>\mu _{yj}</tex>(другими словами - подставим в основную формулу байесовского классификатора вместо <tex>p_y(x)</tex> формулы, которые мы предположили в гипотезе) :<br /><br /> | ||

<tex>a(x) = argmax _{y \in Y} \lambda _y P _y \sum ^{k_y} _{j = 1} N _{yj} exp(-1/2 \rho _{yj} (x, \mu _{yj}))</tex> <br /> <br /> | <tex>a(x) = argmax _{y \in Y} \lambda _y P _y \sum ^{k_y} _{j = 1} N _{yj} exp(-1/2 \rho _{yj} (x, \mu _{yj}))</tex> <br /> <br /> | ||

| Строка 61: | Строка 63: | ||

== См. также == | == См. также == | ||

| - | [[Байесовский классификатор]] | + | *[[Байесовский классификатор]] |

| - | [[EM-алгоритм]] | + | *[[EM-алгоритм]] |

| - | [[Нейронная сеть]] | + | *[[Нейронная сеть]] |

{{Задание|MariaAleshina|Константин Воронцов|8 января 2010}} | {{Задание|MariaAleshina|Константин Воронцов|8 января 2010}} | ||

| + | |||

| + | [[Категория:Байесовская теория классификации]] | ||

| + | [[Категория:Метрические алгоритмы классификации]] | ||

| + | [[Категория:Нейронные сети]] | ||

Текущая версия

Сеть радиальных базисных функций - нейронная сеть прямого распространения сигнала, которая содержит промежуточный (скрытый) слой радиально симметричных нейронов. Такой нейрон преобразовывает расстояние от данного входного вектора до соответствующего ему "центра" по некоторому нелинейному закону (обычно функция Гаусса)[1]. В данной статье мы рассмотрим применение этой нейронной сети к решению задачи классификации с помощью восстановления смесей распределений (частный случай ЕМ-алгоритма)

Содержание |

Понятие радиальной функции

Радиальная функция — это функция , зависящая только от расстояния между

и фиксированной точкой пространства

.

Для определения наших радиальных функий введем метрику:

Нормальное распределение (гауссиан) с диагональной матрицей ковариации

можно записать в виде

где — нормировочный множитель,

— взвешенная евклидова метрика в n-мерном пространстве X:

,

.

Чем меньше расстояние , тем выше значение плотности в точке x. Поэтому плотность

можно рассматривать как функцию близости вектора x к фиксированному центру

.

Постановка задачи

Построить алгоритм, который бы решал задачу классификации байесовским алгоритмом (частный случай EM-алгоритма) в предположении, что плотность распределения представима в виде смеси гауссовских распределений с диагональными матрицами ковариации.

Решение задачи

Пусть - число классов, каждый класс

имеет свою плотность

распределения

и представлен частью выборки

.

Здесь - множество ответов (классов),

,

принадлежит множеству объектов

Гипотеза

Плотности классов , представимы в виде

смесей

компонент. Каждая компонента имеет n-мерную гауссовскую плотность

с параметрами

- центр,

- ковариационная матрица

:

- смесь плотностей

- плотность каждой компоненты смеси (имеет вид гауссианы)

- условия нормировки и неотрицательности весов

Алгоритм классификации

Запишем основную формулу байесовского классификатора

. Здесь

- множество ответов (классов),

принадлежит множеству объектов

- априорная вероятность класса

- функция правдоподобия класса

- цена ошибки на объекте класса

. Выразим плотность каждой компоненты

через взвешенное евклидово расстояние от объекта x до центра компоненты

(другими словами - подставим в основную формулу байесовского классификатора вместо

формулы, которые мы предположили в гипотезе) :

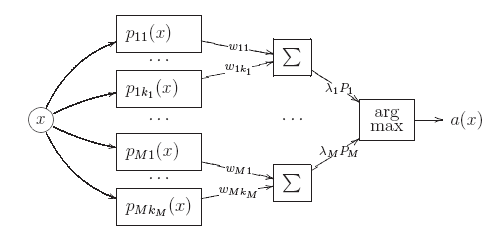

где — нормировочные множители. Алгоритм имеет вид

нейронной сети, состоящей из трёх уровней или слоёв.

Первый слой образован гауссианами

.

На входе они принимают описание объекта x, на выходе выдают оценки близости

объекта x к центрам

, равные значениям плотностей компонент в точке x.

Второй слой состоит из M сумматоров, вычисляющих взвешенные средние этих

оценок с весами . На выходе второго слоя появляются оценки близости

объекта x каждому из классов, равные значениям плотностей классов

.

Третий слой образуется единственным блоком argmax, принимающим окончательное решение об отнесении объекта x к одному из классов.

Таким образом, при классификации объекта x оценивается его близость к каж-

дому из центров по метрике

. Объект относится к тому

классу, к чьим центрам он располагается ближе.

Описанный трёхуровневый алгоритм классификации называется сетью c радиальными базисными функциями или RBF-сетью (radial basis function network). Это одна из разновидностей нейронных сетей.

Обучение RBF-сети

Обучение сводится к восстановлению плотности каждого из классов

с помощью EM-алгоритма. Результатом обучения являются центры

и дис-

персии

компонент

. Интересно отметить, что, оценивая дисперсии,

мы фактически подбираем метрики

, с помощью которых будут вычисляться расстояния до центров

. При использовании Алгоритма, описанного в данной статье, для каждого класса определяется оптимальное число компонент смеси.[1]

Литература

См. также

| | Данная статья является непроверенным учебным заданием.

До указанного срока статья не должна редактироваться другими участниками проекта MachineLearning.ru. По его окончании любой участник вправе исправить данную статью по своему усмотрению и удалить данное предупреждение, выводимое с помощью шаблона {{Задание}}. См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |